超节点算力革命(四)| 超节点产业链图谱分析

2026-02-04

以下文章来源于微信公众号——全球计算联盟GCC

【前文回顾】超节点是一个复杂而精密的系统,其核心思想在于通过深度软硬件协同,将分散的物理资源聚合成一个逻辑上统一、性能强大的算力池。其关键技术包括:高速互联(如华为UB灵衢)构建TB级带宽的高速总线;全局内存统一编址技术形成逻辑统一的寻址空间,简化分布式编程;高密度液冷与供电系统突破物理极限,支撑千瓦级芯片的稳定运行;软件定义调度与AI框架深度适配,实现拓扑感知的资源编排与多策略并行计算。

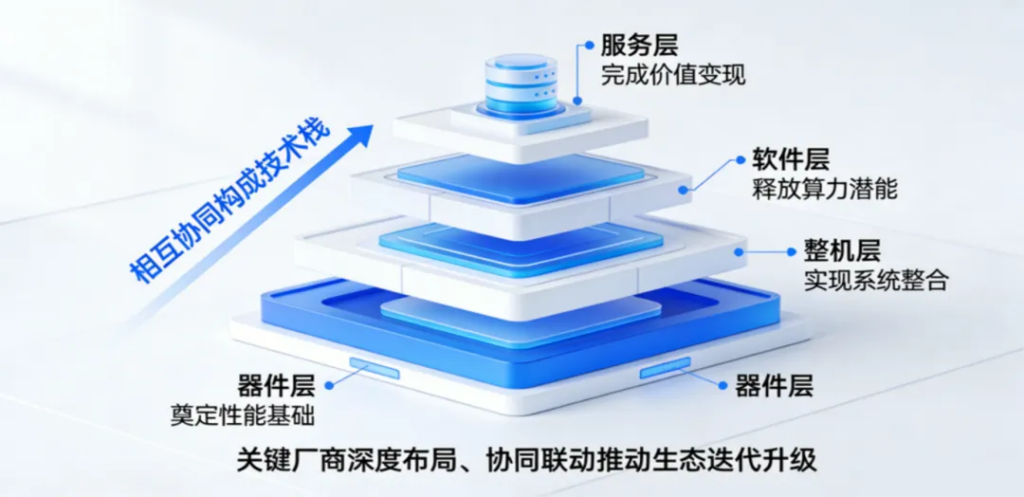

从超节点的体系架构出发,其生态体系可划分为四层技术栈,自底向上依次为器件层、整机层、软件层、服务层,各层级通过协同联动构成完整的技术体系。作为人工智能时代的核心计算单元,超节点具备清晰的系统性技术特征:底层器件为算力性能奠定硬件底座,整机层实现硬件、架构与算力单元的系统集成,软件层通过调度、优化与生态适配释放算力潜能,服务层则完成算力价值的场景化落地与商业化变现,最终形成“硬件筑基、软件赋能、服务落地”的全链路生态闭环。产业链核心厂商在各层级开展深度布局与跨层协同,持续驱动超节点生态的迭代演进与技术升级。

01 关键器件:

技术突破的核心战场

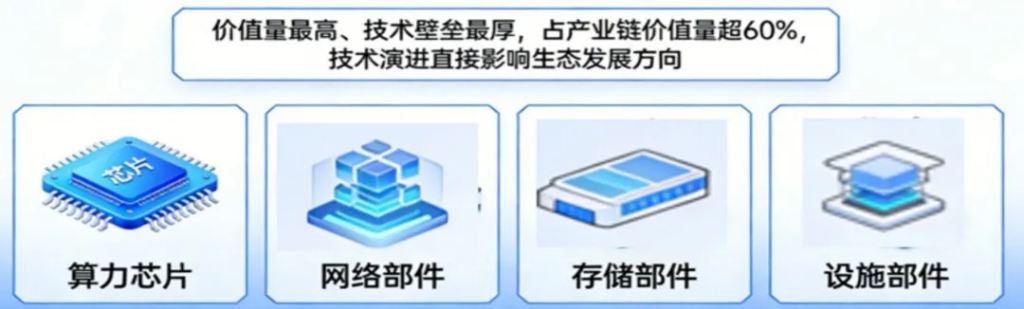

关键器件是超节点生态中价值量最高、技术壁垒最厚的环节,占产业链价值量超过60%,技术演进直接影响整个生态的发展方向,其核心涵盖算力芯片、网络部件、存储部件、供电和散热设施部件四大类,各细分领域头部厂商凭借技术优势占据主导地位,中小厂商聚焦细分赛道突破。

①算力芯片:生态主导权的核心争夺点

AI加速器是超节点的核心“引擎”,主要包括图形处理器(GPU)、神经网络处理器(NPU)、张量处理器(TPU)等专用AI芯片,以及包括提供通用计算与调度能力的CPU。

AI加速器(GPU、NPU等)是超节点进行大规模并行计算、驱动AI模型训练与推理的核心引擎。AI加速器是超节点算力输出的核心,其技术规格聚焦算力密度、能效比与技术生态。当前,主流AI芯片正朝着更高算力密度(FP8/FP4等低精度计算能力)、更大片上缓存(On-chip Cache)、以及更强内置互联能力的方向演进。

- 英伟达BalckWell和Rubin系列:当前核心产品包括Blackwell架构的GB200、GB300系列,以及2026年量产的Rubin系列,其中超节点NVLink72可将72个GPU和36个CPU整合到单一平台,适配NVLink5.0高速互联协议,是超节点高端市场的核心供应商,其生态适配性业界领先;

- 华为昇腾910和950系列:核心产品为昇腾910B、昇腾910C NPU,及即将上市的昇腾950系列,适配华为UB灵衢协议,支撑AtlasSuper Pod系列超节点落地,聚焦国内互联网、政企、运营商、超算中心等市场,构建国产算力生态;

- AMD MI300和MI400系列:依托ROCm开源生态,适配Infinity Fabric/UALink协议,侧重高性价比场景,其ROCm 7.1版本实现多框架适配优化,提升超节点兼容性;

- 国内厂商:百度昆仑芯、寒武纪、沐曦、燧原、壁仞科技、阿里PPU等,核心聚焦国内市场,产品适配国产互联协议与开源生态;

CPU中央处理器:在超节点中,CPU的角色逐渐从主要的计算单元转变为控制、调度、数据预处理和执行非并行任务的核心。其性能直接影响整个系统的任务调度效率和I/O处理能力。

- X86技术路线:Intel的Xeon系列和AMD的EPYC系列因其强大的通用计算能力、丰富的I/O接口和成熟的生态系统,被广泛应用于各类计算节点中 ;

- ARM技术路线:NVIDIA推出的Grace CPU则专为AI和HPC工作负载设计,通过NVLink-C2C技术与GPU紧密耦合,提供了极高的数据交换带宽 ;华为的鲲鹏系列CPU(Kunpeng920、950)基于ARM架构,在通用计算和AI算力节点中扮演着越来越重要的角色 。

②网络部件:低时延协同的关键支撑

Scale-Up 网络指超节点中将“单机柜或相邻机柜内的AI加速器互联”,与Scale-Out(跨机柜)网络形成互补, 主要由高速交换芯片、高速光模块、高速铜缆构成,用于实现单机柜内数十乃至数百个AI芯片的超高速、低延迟互联,需支持内存语义(直接Load/Store)。核心壁垒集中在高速互联技术、协议兼容性与规模化量产能力,Scale UP协议的落地的核心载体,直接决定器件层协同效率。

- 交换芯片(Switch Chip):英伟达(NVSwitch 专门 NVLink协议设计)、博通(Tomahawk Ultra,主导SUE框架研发)、华为(适配UB协议,推出UB交换芯片)、UALink(预计2026年推出商业化芯片)、盛科通信(聚焦以太网交换芯片,适配Scale UP协议),Scale UP交换芯片支持单跳交换拓扑与Mesh拓扑,实现AI加速器间高速内存事务传输。

- 光器件:超节点内实现跨机柜高速互联(> 7m)。传统的光模块厂商,包括中际旭创、天孚通信、新易盛、剑桥科技,核心产品覆盖800G/1.6T规格,适配超节点低时延互联需求。随着超节点的规模、功耗和密度越来越严苛要求,又延伸出CPO(共封装光学)或 NPO(近封装光学)新一代方案,将光引擎(OE)集成于 XPU 封装或近旁,减少光电转换损耗,方案有立讯精密等厂商;注:CPO/NPO技术的交换机和AI加速器将2026年开始规模化商用

- 高速铜缆:共封装铜互连(CPC),聚焦短距离互联场景(<3m),适配超节点内部芯片间、机柜内低时延传输需求,成本仅为同速率光模块的1/3,每Gbps功耗降至0.15W。供应商:立讯精密、泰科电子。

③存储部件:海量数据承载的核心保障

超节点对存储的要求是“高速”与“共享”。高带宽内存(HBM)已成为AI芯片的标配,为计算核心提供海量的数据吞吐能力。在系统层面,为了打破内存墙,CXL(Compute Express Link)等协议开始普及,允许CPU与加速器、内存、存储设备共享内存池,实现内存资源的池化和统一编址 。

- HBM:三星、SK海力士、镁光为核心厂商,产品覆盖HBM3/HBM3e规格,带宽达1TB/s以上,最新HBM4已经实现量产;国产长鑫存储已经实现HBM3的规模量产。

- SSD:三星、西部数据、铠侠,通过PCIe 5.0实现CPU之间的互联,侧重高IOPS与低时延,适配超节点分布式存储架构;国产厂商长江存储在快速崛起,切入国产超节点供应链。

④功能和散热设施部件:稳定运行的基础支撑

超节点极高的算力密度带来了巨大的功耗和散热挑战。单个超节点机柜的功率可达100kW以上,传统风冷已无法满足需求。因此,液冷技术,特别是冷板式液冷和浸没式液冷,已成为超节点数据中心的标配。此外,高压直流(HVDC)供电、冗余配电设计(如N+N)以及高密度的铜缆和光纤布线系统也是关键的设施部件 。核心壁垒集中在高效散热技术、电源能效优化与规模化适配能力,需与整机层机柜、液冷系统协同设计。

- 电源:超节点普遍采用高压直流供电(如±400 VDC高压直流),并趋向于分布式供电架构,为不同计算模块独立供电和监控。供应商: Vertiv维谛、台达、华为、艾默生,核心产品聚焦高效能电源模块,适配超节点高功耗需求,台达产品已应用于全球多地AI数据中心超节点部署。

- 散热器件:核心产品包括液冷板、CDU,采用液冷等高效散热方案,适配高密度集成需求。供应商:英维克、台达、华为、Vertiv维谛、Schneider Electric等是基础设施巨头。

超节点的硬件层生态是由多样化芯片、高速互联网络和高性能存储接口共同构成的复杂系统。其发展趋势是走向更高的带宽、更低的延迟、更强的异构融合能力以及更开放的互联标准。

02 整机层:

系统集成的技术高地

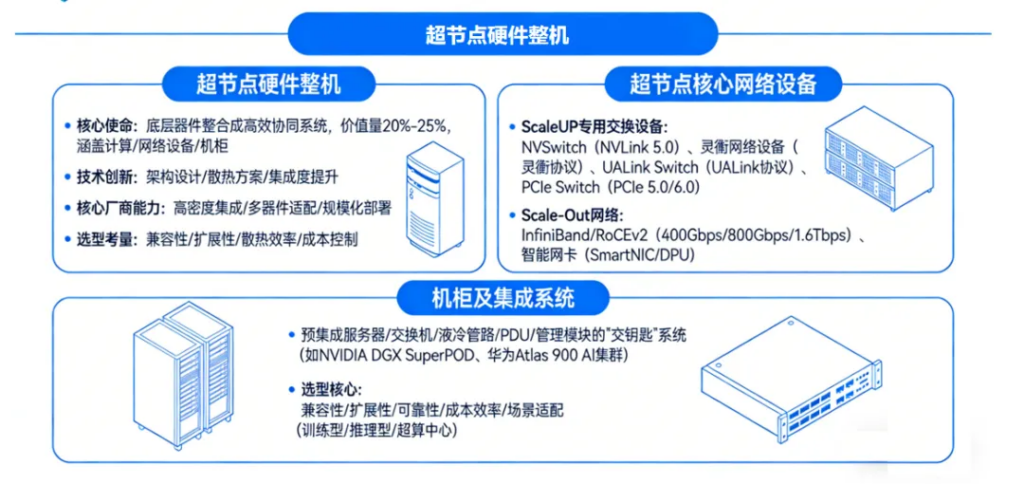

整机层承担着将底层器件整合成高效协同系统的关键使命,价值量占比约20%-25%,核心涵盖计算、网络设备、机柜三大类产品,技术创新主要体现在架构设计、散热方案、集成度提升等方面,核心厂商聚焦高密度集成、多器件适配与规模化部署能力,选型核心考量因素包括兼容性、扩展性、散热效率与成本控制。

①超节点硬件整机

超节点机柜机框需兼顾高密度集成、散热兼容与标准化扩展。超节点整机产品遵循相关Scale UP协议(适配NVLink、华为UB、SUE等多种高速互联协议),同时满足软件层操作系统与调度软件的适配要求,其核心涵盖超节点计算、网络设备、机柜。

- 英伟达:超节点整机方案龙头,核心产品为GB200 NVL72超节点,单机柜集成72个Blackwell GPU,适配NVLink5.0协议,搭配专属Scale UP网络设备NVSwitch、IB交换机及OCS全光设备,适配OCP 最新机框规范,聚焦高端AI训练场景,是全球万亿参数大模型训练的核心整机方案供应商;

- 华为:2025年Atlas Super Pod超节点出货500多套,核心产品CloudMatrix 384跨机柜超节点(集成384个昇腾910C NPU,峰值算力300 PFLOPS),采用液冷设计,适配自身UB协议与灵衢协议,同时布局全品类配套网络设备及机框产品——灵衢网络设备、华为RoCE交换机(CloudEngine系列)和OCS全光设备。中国电信在广东韶关上线的全球首个智算昇腾超节点即采用华为整机、网络设备及机框一体化方案;

- 中科曙光:国产核心厂商,推出scaleX系列超节点,其中scaleX640是单机柜级640卡超节点,采用“一拖二”高密架构,适配海光、寒武纪、沐曦、燧原等国产加速卡与国际主流GPU,适配Scale UP协议与以太网协议,兼容PCIe Switch及国产RoCE交换机,聚焦超算中心等场景;

- 国内其他厂商:新华三(推出UniPoD S80000超节点,基于以太协议和PCIe协议,适配多种算力芯片,配套其RoCE交换机)、浪潮(适配英伟达GPU与国产XPU,兼容RoCE交换机,构建一体化方案);

②网络设备

超节点核心网络设备是保障超节点低时延、高带宽互联的核心支撑。

ScaleUP专用交换设备:包括英伟达NVSwitch(适配NVLink 5.0协议,支撑超节点72个GPU全互联)、华为灵衢网络设备(适配灵衢协议,支撑384个NPU互联)、UALink Switch(AMD、Intel主导,适配UALink协议,支撑多厂商异构芯片协同)、PCIe Switch(美满电子,适配PCIe 5.0/6.0,支撑机柜内短距离高速互联,国产超节点采用);

Scale-Out网络: 负责连接多个超节点机柜,形成更大规模的算力集群。主流技术包括InfiniBand和RoCEv2(RDMA over Converged Ethernet)。当前,400Gbps/800Gbps以太网技术已成为主流,并向1.6Tbps演进。智能网卡(SmartNIC/DPU)在此环节扮演重要角色,可卸载网络协议和虚拟化功能,为主CPU减负。

- RoCE交换机:华为CloudEngine系列、思科Nexus系列、Arista 7050X系列、新华三S12500X系列,核心优化RDMA传输性能,降低互联延迟;

- 英伟达InfiniBand交换机:Spectrum-X系列(面向大规模AI训练与云原生负载),全面优化RDMA与GPU直连通信效率,实现超低延迟与超高吞吐的异构计算互联。

③机柜及集成系统

超节点通常以整机柜的形式交付,是预集成了服务器、交换机、液冷管路、供配电单元(PDU)以及管理模块的“交钥匙”系统。这种模式简化了部署,保证了性能和可靠性 。NVIDIA的DGX SuperPOD和华为的Atlas 900 AI集群就是典型的整机柜交付产品。

结合产业实际,超节点整机选型需围绕“兼容性、扩展性、可靠性、成本效率”,兼顾场景适配性。

03 软件层生态:

算力释放的核心支撑,开源与封闭并行

软件生态是实现超节点“巨型单机系统”概念的核心支撑,核心聚焦AI框架适配、全流程工具链搭建与应用适配,核心价值是释放硬件算力,破解“硬件性能过剩、软件适配不足”的痛点,关键厂商分为封闭生态主导者与开源生态共建者,竞争焦点集中在适配能力、工具链完整性与生态兼容性。可以说,软件层的优化程度,直接决定了硬件算力的实际释放效率 。

①AI框架的适配优化

AI框架是超节点算力调度与模型运行的核心载体,适配优化核心聚焦与超节点硬件(多算力芯片、高速互联)的兼容性、分布式训练/推理性能调优,核心方向包括多芯片协同调度、通信效率优化、内存池化管理,需与Scale UP协议、互联协议深度适配,实现算力高效利用。

- 兼容性适配: 主流AI框架(如PyTorch, TensorFlow)最初主要围绕NVIDIA的CUDA生态进行开发。为了让这些框架能够运行在非NVIDIA硬件(如华为昇腾NPU)上,硬件厂商需要提供专门的适配插件。如,华为为PyTorch开发了torch_npu插件(Ascend Adapter for PyTorch),它将PyTorch的算子调用重定向到底层的昇腾计算架构网络(CANN)上,从而实现了框架的兼容 。

- 性能调优方向: 仅实现兼容是远远不够的,深度性能优化是关键。这包括: -算子融合与优化: 针对特定硬件的计算特性,开发高性能的自定义算子,并将多个小算子融合成一个大算子,以减少Kernel启动开销和内存交互。 -图编译优化: 通过静态图编译技术(如华为MindSpore的MindRT和Meta AI的PyTorch 2.0 torch.compile),在执行前对整个计算图进行优化,如算子重排、内存复用等。 -自动并行: 框架需要能够感知超节点的拓扑结构,自动地将大模型切分到不同的计算单元上,并选择最优的并行策略(数据并行、张量并行、流水线并行、专家并行等)。华为的MindSpore框架在这方面进行了深度优化,能够更好地利用昇腾超节点的硬件特性 。

- NVIDIA CUDA: 目前最成熟、最完善的软件生态,包含了从驱动、编译器、各种库(cuDNN, NCCL)到开发工具的全套解决方案;

- AMD ROCm是 AMD 推出的开源异构计算软件栈,为基于 AMD GPU(Instinct 数据中心加速卡)的AI训练 / 推理与高性能计算(HPC)提供完整的编程环境与优化支持。它采用开放架构 + 模块化设计,与 NVIDIA CUDA 形成差异化竞争,旨在打破厂商锁定,构建跨硬件的统一计算生态

- 华为昇腾CANN与MindSpore:完全开源开放,围绕昇腾芯片构建的全栈AI软件平台。CANN是底层的计算架构网络,而MindSpore是原生适配昇腾的AI框架,两者协同构成了昇腾生态的核心 。

- 其他开源社区: PyTorch、TensorFlow、JAX等开源AI框架,以及背后的Meta、Google等公司,是软件生态的重要推动者。它们通过插件机制支持不同硬件的接入 。

②全流程工具链的搭建

全流程工具链涵盖开发、测试、部署三大环节,核心目标是实现超节点从模型开发到落地的高效协同,降低开发门槛,提升运维效率,各环节工具需适配超节点分布式架构与多厂商硬件,核心壁垒集中在工具链协同性、兼容性与自动化能力。

- 开发工具: 包括编译器(如CANN)、性能分析工具(Profiler)、调试器(Debugger)等,帮助开发者深入底层,定位性能瓶颈。

- 测试与CI/CD工具: 自动化测试框架和持续集成/持续部署(CI/CD)流水线(如Jenkins, GitLab CI/CD)对于保障大规模分布式训练任务的稳定性和可重复性至关重要 。

- 部署工具: 包括模型转换与优化工具(将训练好的模型转换为适合推理的格式)、推理服务器(如Triton Inference Server)以及容器化部署方案(Docker, Kubernetes),以实现模型的灵活、高效部署。

③开放集合通信

集合通信(Collective Communication)是大规模并行计算的灵魂,它定义了多个计算节点之间如何进行同步、广播、规约(Reduce)等协同操作。开放的集合通信社区和优化的算子库,是实现高效异构算力协同的基石。

开放集合通信社区

- 专有的通信库(如NVIDIA的NCCL):与硬件深度绑定。

- 华为开源了其昇腾通信库HCCL的架构和接口,为社区贡献了Ring、Mesh等多种拓扑算法的实现 。这些开源实践,为构建更广泛的异构通信生态奠定了基础。

- 开放集合通信社区(如OpenUCL)旨在创建与硬件解耦、可扩展的通信框架,允许第三方硬件通过插件的形式接入,从而打破单一厂商的生态锁定。

04服务层生态:

商业化落地的核心载体

服务层生态聚焦于超节点的全生命周期管理与价值变现,核心涵盖云服务、运维管理、调度系统,各模块协同承接软硬件能力,结合具体行业场景实现商业化落地,关键厂商分为云服务厂商、专业运维厂商与行业解决方案厂商,竞争焦点集中在场景适配能力、服务响应效率与成本控制。

①云服务:超节点算力的规模化输出

将超节点算力封装为云服务(AI训练云、推理云、超算云),提供弹性算力租赁、模型托管等服务,适配中小厂商与科研机构的算力需求,核心壁垒集中在算力调度能力、服务稳定性与成本控制。

关键厂商:亚马逊AWS(推出Trainium云服务)、微软Azure(联合英伟达、AMD,提供超节点弹性算力服务)、谷歌Cloud(基于自身TPU超节点与英伟达GPU超节点)、华为云(基于Atlas超节点,推出智能云服务)、阿里云(推出AI训练与推理云服务,优化大模型适配性能)、中国电信(推出智算超节点云服务)。

②运维管理:超节点稳定运行的保障

涵盖资产全生命周期管理、分层实时监控、智能告警与故障处理、自动化巡检,核心适配超节点规模化、高密度的特点,需支持多厂商硬件与软件的统一管理,核心壁垒集中在监控精度、故障定位效率与自动化能力。

关键厂商:华为(推出昇腾超节点运维平台iMaster CCAE,一站式跨域全栈管理与智能运维平台)、英伟达(NVIDIA Fleet Command,适配自身超节点,实现远程运维与调度)、戴尔(OpenManage,适配自身超节点方案,提供全生命周期运维服务)。

③调度系统:算力高效利用的核心

实现超节点内部及集群间的算力资源、存储资源、网络资源的动态调度,优化任务分配,降低延迟,提升算力利用率,核心适配异构算力协同与多厂商硬件混合部署场景。

关键厂商:华为(推出超节点全局调度系统,适配灵衢协议,实现万卡级算力调度)、谷歌(自研调度系统,适配TPU超节点,优化分布式训练任务分配)、字节跳动(自研调度平台,适配多厂商超节点,聚焦大模型训练场景)、阿里云(容器调度系统,实现资源弹性调度)。

云服务厂商整合超节点硬件算力,通过调度系统实现资源动态分配,满足不同用户的算力需求;运维管理模块实时监控超节点运行状态,及时处理故障,保障云服务与行业解决方案的稳定运行;行业解决方案厂商基于云服务与调度能力,结合行业需求,整合软硬件资源,推出定制化方案,实现超节点价值变现;各模块均需承接软件层的适配能力与器件层、整机层的硬件性能,形成跨层级协同。

05 开放联盟与技术共建:

多路线竞争,标准化加速

超节点作为一个极其复杂的系统工程,任何单一厂商都难以独立覆盖所有环节。因此,构建一个开放、协同、共赢的生态合作体系,是推动超节点技术成熟和产业繁荣的必由之路。随着超节点成为战略要地,围绕核心互联协议的“标准之争”愈演愈烈,催生了多个技术联盟。这些联盟通过共建技术标准、共享IP、协同开发等方式,试图构建各自的生态护城河,同时也推动了整个产业的技术进步。

- NVLink生态(NVIDIA主导):合作机制: NVLink最初是NVIDIA的独家封闭技术,构成了其CUDA生态的硬件基石 。然而,面对日益增长的开放呼声和竞争压力,NVIDIA的策略也在演变。自2025年起,NVIDIA宣布向第三方开放NVLink IP授权,启动了NVLink Fusion计划 。该计划允许合作伙伴(如CPU或ASIC厂商)将其芯片通过NVLink与NVIDIA GPU进行高速互联,这标志着NVIDIA从“垂直整合”向“主导下的开放”转型。

- 华为UB(UnifiedBus)生态:合作机制: 华为选择了“开源开放”的路径。其自研的高速互联总线标准UB(灵衢),从设计之初就定位为开放标准。华为已向产业界正式开放了灵衢2.0技术规范,邀请合作伙伴共同开发、使用和完善该标准,旨在构建一个自主可控的国产算力底座 。 UB协议通过系统性创新,实现了多类型计算资源(NPU、CPU、内存等)的统一互联和高效协同。华为基于UB技术打造的CloudMatrix 384超节点,是其集中体现 。

- UALink(Ultra Accelerator Link)联盟:合作机制: UALink是由AMD、Intel、HPE、Microsoft、Meta等行业巨头联合发起的开放标准组织,旨在定义一种用于连接AI加速器的开放、高效的Scale-Up互联标准,目标是直接挑战NVIDIA NVLink的主导地位。这是一个典型的“多极制衡”型联盟,通过联合制定标准来避免被单一厂商锁定。

- SUE(Scale-up Unified Ecosystem)联盟:合作机制: SUE由网络巨头博通(Broadcom)主导,联合了多家服务器和AI芯片厂商。SUE的核心理念是利用以太网技术,一站式跨域全栈管理与智能运维平台,来构建开放的Scale-Up网络, 撬动以太网庞大的生态系统和成熟的技术。

技术路线差异与发展趋势预判

- 路线差异:-私有协议vs. 开放标准: NVLink代表了从私有技术逐步走向有限开放的路线,旨在维持自身生态主导地位。而UALink和华为UB则代表了更为彻底的开放标准路线,旨在打破单一厂商垄断,促进产业多元化。-专用总线vs. 以太网演进: NVLink、UB和UALink本质上是专为AI互联设计的“专用总线”,追求极致的低延迟和高带宽。而SUE则代表了另一条思路,即在成熟的以太网技术上演进,利用其规模效应和成本优势。

- 发展趋势预判:-开放与开源成为主流: 长期来看,封闭的生态系统难以持续。无论是NVIDIA开放NVLink,还是华为力推UB开源,都表明“开放共建”已成为行业共识 。未来,单一厂商的技术壁垒将被逐步打破,基于开放标准的异构融合将成为可能。-多种协议并存与互通:短期内,上述几大技术联盟将继续并存和竞争。数据中心可能会出现支持多种互联协议的“混合”超节点形态。CXL、UCIe等芯粒(Chiplet)互联标准的成熟,将为不同协议间的互通提供底层支持,最终可能走向更高层次的融合。

06结语

超节点生态正处在一个技术爆炸、标准重塑、群雄逐鹿的变革时代。从底层的器件创新,到顶层的服务落地,再到开放的生态合作与复杂的异构融合,每一个环节都充满了挑战与机遇。未来,那些能够构建最强大、最开放、最协同生态的参与者,将最终定义智能时代的算力基石,并分享由此带来的巨大价值。

更多超节点相关议题

将在2026 Open AI Infra

Summit上迎来集中探讨与实践交流。无论你是技术研发人员、企业决策者还是科研工作者,都能在这里突破瓶颈、链接资源、预判趋势。

现大会预报名通道已开启,展位与赞助席位已同步开放,欢迎扫描下方二维码进入预报名通道,共话下一代算力格局!